LDA などのトピックモデルの評価指標として、Perplexity と Coherence の 2 つが広く使われています。

Perplexity はモデルの予測性能を測るための指標であり、Coherence は抽出されたトピックの品質を評価するための指標です。

トピックモデルは確率モデルであるため、Perplexity の定義は明確です。

一方、Coherence は「トピックが人間にとって分かりやすいかどうか」を評価する必要があるため、その算出方法について様々な議論があります。

本記事では、Coherence に関する研究の中で、主要な流れを作っている、特に重要な 5 つの論文をピックアップして紹介したいと思います。

Coherence とは

Coherence は、「トピックが人間にとって分かりやすいか」を表す指標です。

例えば、トピックが

- { farmers, farm, food, rice, agriculture }

の単語からなる場合、このトピックが農業に関するものだということは容易に分かります。

したがって、このトピックは Coherence が高いと言えます。

一方、トピックが

- { stories, undated, receive, scheduled, clients }

の単語からなる場合、このトピックは Coherence が低いと言えます。

この例は非常に極端な場合ですが、実際にはもっと微妙な場合にも Coherence を算出する必要があります。

「人間にとっての分かりやすさ(Human-Interpretability)」という曖昧な指標をどのように算出するのかが Coherence 研究のポイントとなります。

上記の例を見ても分かるように、Coherence の算出には、トピックに含まれる単語間の類似度が大きな役割を果たします。

それでは、論文を見ていきましょう。

Reading Tea Leaves: How Humans Interpret Topic Models

- http://www.umiacs.umd.edu/~jbg/docs/nips2009-rtl.pdf

- Chang(Facebook), Boyd-Graber, Gerrish, Wang, Blei

- 2009 NIPS

トピックモデルの評価指標として Coherence を提案した最初の論文。

Word Intrusion(単語の押しつけ)という方法でトピックの Coherence を人間に評価させる。

Word Intrusion とは、トピックのトップ N個の単語群の中に、一つだけ別の単語を混ぜて、人間に見つけさせるという作業のこと。

例えば、{ dog, cat, horse, apple, pig, cow } の中から仲間はずれを見つけさせる。

これは容易だが、例えば { car, teacher, platypus, agile, blue, Zaire } では難しい。

その理由は、前者のトピックは Coherence が高く、後者は Coherence が低いからであると考える。

この作業を何人かにやらせて、仲間はずれの発見成功率によって Coherence を評価する。

pLSI, LDA, CTM の 3 つのモデルに対して、この Coherence を測定。

CTM は Perplexity が高いが、Coherence は低くなることが分かった。

Automatic Evaluation of Topic Coherence

- http://www.aclweb.org/anthology/N10-1012

- Newman(UCI), Lau, Grieser, Baldwin

- 2010 NAACL HLT

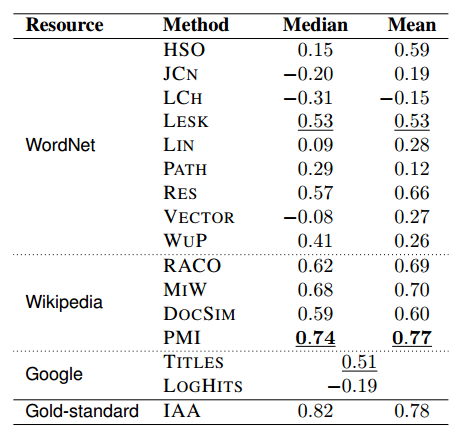

Chang(2009)では、Coherence を人間に評価させたが、この論文では、人間を使わずに評価する方法を提案する。

基本的に、トピックのトップ N単語に対して、各単語間の類似度を計算し、その平均値、もしくは中央値を Coherence とする。

この論文の焦点は、どのような単語間類似度を選べば良いかであり、

様々なコーパスと様々な類似度関数を調べ上げ、人間による評価に一番近い物を探している。

人間による評価方法は、Chang(2009)とは異なり、もっと直接的な方法である。

トピックのトップ N単語を人間に提示し、それらの関連性について 3段階評価を行ってもらう(良い、中間、悪い)。

単語間類似度により算出した Coherence と、人間による 3段階評価のスピアマン相関を見て類似度関数の良し悪しを測る。

参照コーパスとして Wikipedia を、単語間類似度として PMI (pointwise mutual information) を使うのが良い。

Optimizing Semantic Coherence in Topic Models

- http://mimno.infosci.cornell.edu/papers/mimno-semantic-emnlp.pdf

- Mimno, Wallach(UMass), Talley, Leenders, McCallum

- 2011 EMNLP

Newman(2010)では、Coherence の算出に参照コーパスを用意しなければならなかったが、

この論文では、学習コーパスのみを用いた Coherence の算出方法を提案する。

Coherence の算出方法は Newman(2010) と同じで、単語間類似度としては対数条件付き確率(LCP)を用いる。

これにより計算された Coherence が人間による評価に近いことを示した。

人間による評価方法は、Newman(2010)と同じ直接的な 3段階評価を用いた。

ちなみに、この論文では、Word Intrusion は Chain みたいなものが起こるとダメだ的な指摘もしている。

Chain の例: { apple, appl-pie, meat-pie, meat, crab-meat, crab }

Chained Topic は Coherence は低いのに、Word Intrusion で仲間はずれを見つけやすい。

さらにこの論文では、この論文で提案した Coherence が高くなるような新たなトピックモデルも提案している。

UMass Coherence と呼ばれ、参照コーパスを必要としないため、ライブラリに実装しやすい。

実際、gensim の LDA において、top_topics() という関数で実装されている。

UCI Coherence と UMass Coherence を比較したこちらの論文紹介が非常に参考になります。

Evaluating Topic Coherence Using Distributional Semantics

- http://www.aclweb.org/anthology/W13-0102

- Aletras, Stevenson

- 2013 IWCS

統計的意味論における類似度を Coherence の自動計算にあてはめてみたという論文。

Newman(2009)では、単語間類似度に PMI を用いたが、これを意味空間(Semantic Space)上の類似度に変えてみる。

分布仮説に基づき、意味空間を共起についての情報量(PMI, NPMI)を用いて作成。(参照コーパスは Wikipedia)

ただし、そのままだと意味空間の次元が大きくなりすぎるので、Islam(2006) で提案された Reduced Semantic Space と

トピックに現れる単語のみを用いた Topic Word Space の 2 つを考える。

意味空間上の類似度として、コサイン類似度、Dice係数、Jaccard係数の 3 つを調べる。

もう一つ、トピックの重心(Centroid)からのコサイン類似度の平均値から算出した Coherence も調べる。

この 16個(=2×2×4)を人間による評価とのスピアマン相関により評価。

人間による評価は 3 段階評価をクラウドソーシングにより実施。

結果としては、

- Topic Word Space が良い

- コサイン類似度が平均的に良い

- PMI と NPMI は同じくらいか

とりあえず既存手法で最も良い Newman(2009) よりは良くなったので、意味論的なアプローチは有効。

NPMI はコサイン類似度に限らずいい値が出たので意味論的なアプローチに向いている。

Machine Reading Tea Leaves: Automatically Evaluating Topic Coherence and Topic Model Quality

- http://www.aclweb.org/anthology/E14-1056

- Lau, Newman(Google), Baldwin

- 2014 EACL

この論文では、上記4つの方法を俯瞰的に比較している。

モデルレベルでの Coherence とトピックレベルでの Coherence を分けて考える。

まず、モデルレベルの Coherence はトピックレベルの Coherence の平均値であるとする。

pLSI, LDA, CTM の 3 つのトピックモデルに対して、トピック数 50, 100, 150 の 3 つを作る(計9つ)

これら 9 つのモデルのトピックに対して Word Intrusion と直接的な 3 段階評価法で人間による評価を行う。

手法としては、Newman(PMI), Newman改(NPMI), Mimno(LCP), Aletras(DS) および著者の提案した Auto-WI を人間による評価とピアソン相関で比較する。

モデルレベルでは人間による Word Intrusion と直接的な 3 段階評価法には強い相関があり、ほとんど同じと言ってよい。

Word Intrusion に対しては Auto-WI が最も相関が高く、直接的な 3 段階評価法に対しては NMPI が最も相関が高く、Wikipedia に限ると LCP が最も相関が高くなった。

また、参照コーパスとして学習コーパスと同じドメインを用いると良い。

次に、トピックレベルでの相関を見てみたが、非常に低い。

これは本質的な難しさがあり、人間同士を比較してもばらばらになる。

人間による評価値を 2 グループに分けてそれらの相関をとり、その値に近い相関が出れば、人間と同じレベルの評価ができる手法とみなす。

モデルレベルと同様の実験をしたが、NPMI と DS の 2 つの手法が人間と同じレベルの評価ができることが分かった。

宣伝

1/28(木)の第8回『トピックモデルによる統計的潜在意味解析』読書会で発表します!

皆さまぜひ聞きに来てください!

トピックモデルによる統計的潜在意味解析 (自然言語処理シリーズ)

- 作者: 佐藤一誠,奥村学

- 出版社/メーカー: コロナ社

- 発売日: 2015/03/13

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (5件) を見る